Der technische Fortschritt künstlicher Intelligenz hat sich in den letzten zehn Jahren enorm beschleunigt. Mit ChatGPT ist diese Entwicklung auch über Fachkreise hinaus sichtbar und die Nutzung von leistungsstarken KI-Systemen beinahe alltäglich geworden. Aber welche Gefahren birgt die neue Technologie und welche Regeln müssen wir aufstellen, um eine nachhaltige Entwicklung von künstlicher Intelligenz zu ermöglichen?

Wissen Sie, warum Sie hier sind?

Warum lesen Sie gerade diesen Text? Warum wurde dieser Artikel in Ihrer Suchmaschine weiter oben angezeigt als ein anderer? Mit großer Wahrscheinlichkeit hatte eine Künstliche Intelligenz (KI) hierbei ihre virtuellen Finger im Spiel. Oft ist das gar nicht so leicht zu erkennen.

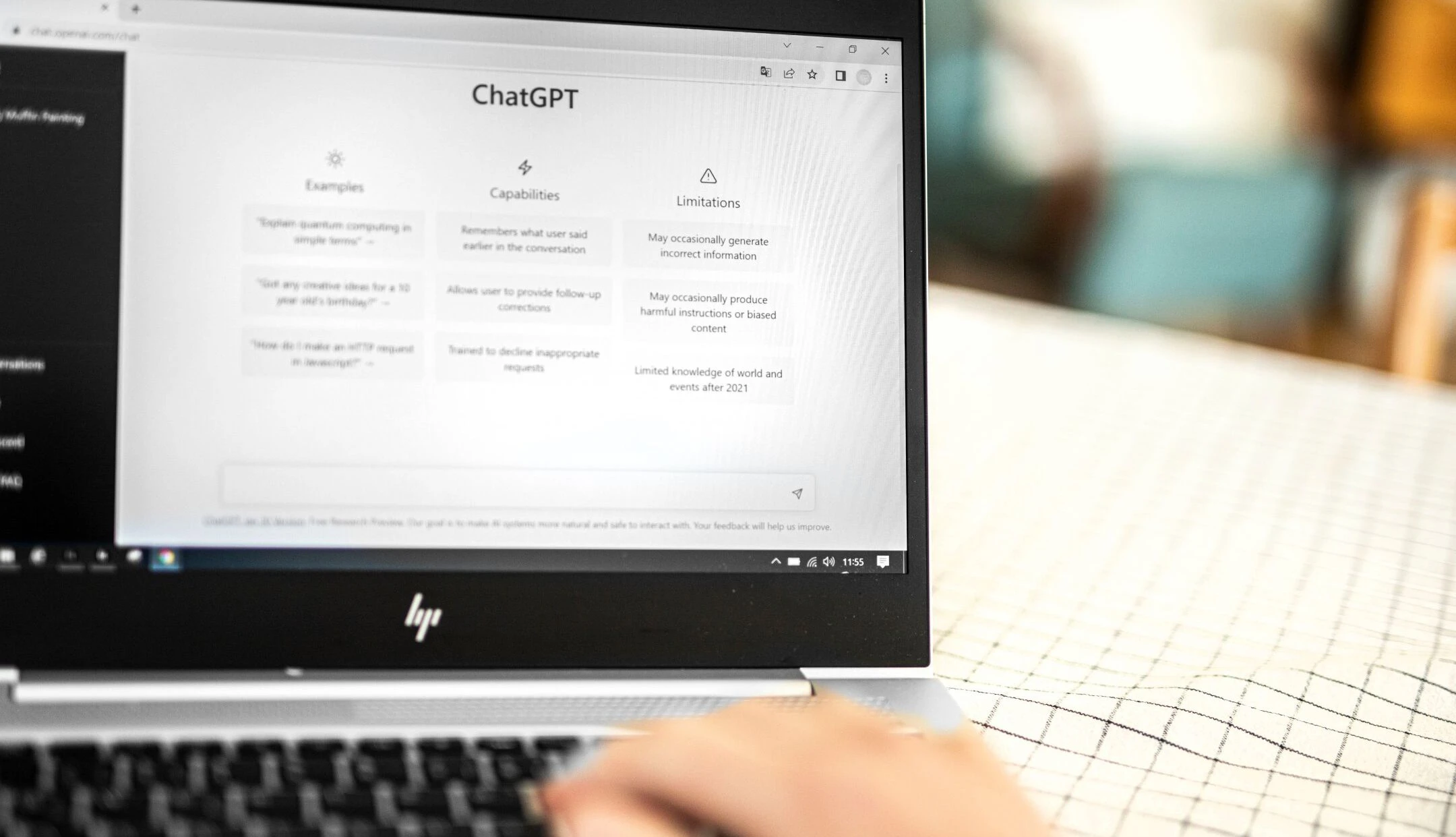

Spätestens seit dem weltweiten Erfolg von ChatGPT ist KI im Mainstream angekommen. Von Suchmaschinen und Online-Übersetzern über Spracherkennung und Social-Media-Algorithmen bis hin zu automatisierten Bankgeschäften. Die breite Nutzung von KI-Systemen stellt uns vor neue ethische Herausforderungen. Wie müssen diese Technologien reguliert werden, damit ein sozial und ökologisch nachhaltiger Umgang mit KI möglich ist?

Sabine Köszegi ist Organisations- und Arbeitswissenschafterin und Professorin an der Technischen Universität Wien. Seit Jahren arbeitet sie an der Schnittstelle zwischen Technik, Mensch und Arbeit und war an der Entwicklung des regulatorischen Rahmenwerks beteiligt, das jetzt in Form des "EU AI-Acts" Europäische Rechtsnorm wird. Im Gespräch mit News.at teilt sie ihre Erfahrungen mit den Herausforderungen und Lösungsansätzen der KI-Entwicklung.

Grundlagen der Ethik in der KI-Entwicklung

Vom Tiktok-Feed über den AMS-Algorithmus bis hin zu moderner Gesichtserkennungssoftware - KI-Systeme spielen eine immer größere Rolle in unserer Gesellschaft. Bei Bildgenerierungsprogrammen wie Midjourney oder bei den Musikvorschlägen von Spotify ist es relativ offensichtlich, dass eine KI am Werk ist. Dass Paypal aber eine KI einsetzt, um Betrugsfälle aufzuspüren, und Versicherungen ihre Risikoanalyse teilweise mit Machine-Learning-Modellen unterstützt, ist keineswegs auf den ersten Blick erkennbar.

Die breiten Anwendungsmöglichkeiten von KI führen zu einer großen Bandbreite an ethischen Herausforderungen. Wie gehen Programme mit unseren Daten um? Bei wem liegt die Verantwortung für Fehler? Wie kann man Diskriminierung vorbeugen? Diese praktischen Fragen müssen beantwortet werden, um einen nachhaltigen Umgang mit KI zu ermöglichen. Und dann bleibt noch die Frage: Wie sorgen wir dafür, dass wir nicht die Kontrolle verlieren und auf ein apokalyptisches Science-Fiction-Szenario zusteuern, in der die Menschheit von ihrer eigenen Erfindung ausgelöscht wird?

Generative KI und Generelle KI

Was ist dran an diesen Horrorvorstellungen vom Ende der menschlichen Zivilisation? Es ist wichtig, zwischen zwei unterschiedlichen Formen der KI zu unterscheiden: Zum einen gibt es die generative KI, die in der Lage ist, Bilder und Texte herzustellen oder Musik zu komponieren. Daneben gibt es eine Diskussion über die sogenannte generelle KI, eine KI, "die quasi an menschliche Intelligenz herankommt", erklärt Köszegi.

Mir ist kein System bekannt, das auch nur annähernd an natürliches menschliches Denken herankommen würde

Während es generative KI bereits in vielen Anwendungen gibt, etwa bei ChatGPT, ist die generelle KI bisher nur eine Zukunftsvorstellung. "Mir ist kein System bekannt, das auch nur annähernd an natürliches menschliches Denken herankommen würde", so Köszegi. Obwohl die generelle KI also bislang nur Science Fiction ist, gibt es im Internet, aber auch unter Expertinnen und Experten, Diskussionen über die Risiken einer solchen Intelligenz. Könnte eine Maschine so schlau werden, dass sie einen eigenen Willen entwickelt, uns gegebenenfalls sogar auslöschen möchte? Viele halten das für möglich.

Exkurs: Das Büroklammern-Argument

Einer von ihnen ist der Philosoph Nick Bostrom. Mit seinem Büroklammern-Argument hat er bereits 2003 die Möglichkeit eines solchen apokalyptischen Szenarios formuliert. In diesem Gedankenexperiment gibt es eine KI, die darauf programmiert ist, möglichst viele Büroklammern herzustellen. Wenn die KI nicht darauf trainiert wurde, grundlegende menschliche Werte zu achten, so Bostrom, würde sie sehr schnell dazu übergehen, alle verfügbaren Ressourcen zur Herstellung von Büroklammern zu nutzen. Die KI würde versuchen, die gesamte Materie des Universums in Büroklammern zu verwandeln, einschließlich aller Lebewesen und uns Menschen.

Auch wenn dieses Beispiel sehr abstrus wirkt, steht es exemplarisch für eine reale Angst, die viele Menschen in Bezug auf KI haben. Was, wenn wir sie nicht mehr kontrollieren können? Was, wenn sie uns eines Tages über den Kopf wächst und eine so harmlose Aufgabe wie das Herstellen von Büroklammern das Ende allen Lebens bedeutet?

Mehr zum Thema KI:

Bleiben wir bei der Realität: Wir haben auch so genug Probleme!

Aber kann eine KI wirklich einen Eigenwillen haben? Kann KI einen eigenen Lebenssinn entwickeln? "Für die KI gibt es ganz klare Anweisungen, eine Aneinanderreihung an mathematischen Operationen – das ist kein Sinn", erklärt Sabine Köszegi. Die Sinngebung erfolge immer beim Menschen.

"Ich finde ChatGPT schon spooky genug", sagt Köszegi. "Auch damit kann man schon genug Positives wie Negatives anrichten, dazu braucht es diese Horrorvorstellungen nicht." Die Idee, dass die KI schon bald sehr viel intelligenter sein wird als der Mensch, hält sie für unrealistisch. "Wir verstehen immer noch nicht genau, wie das menschliche Hirn, Persönlichkeit, Psyche oder Gedanken funktionieren." Es sei also voreilig zu glauben, dass die KI bald alle menschlichen Leistungen in den Schatten stellen wird. "Aus heutiger Sicher der Forschung ist es nicht absehbar, dass wir in nächster Zeit eine generelle künstliche Intelligenz sehen werden", beruhigt Köszegi. Prognosen über den Fortschritt von KI seien oft übertrieben. "Vor zehn Jahren wurde schon gesagt, dass wir alle autonom fahren werden. Und jetzt suchen die Briten händeringend LKW-Fahrer."

Die zentralen ethischen Fragen unserer Zeit drehen sich nicht um irgendwelche apokalyptischen Superintelligenzen. Die Technologien, die es bereits gibt, sorgen für genügend Kopfzerbrechen und regulatorische Herausforderungen.

Die KI stellt uns vor eine ganze Reihe an Herausforderungen

© iStockphoto.comAktuelle ethische Herausforderungen in der KI

Auch ohne intelligente Massenvernichtungswaffen stellt uns der Umgang mit KI vor ernstzunehmende Aufgaben. Die Liste der ethischen Problemfelder, die bereits heute bewältigt werden müssen, ist lang:

Fairness und Inklusion

KI- und Machine-Learning-Systeme werden mit einer Fülle an Daten trainiert. Diese Daten können unvollständig, korrumpiert oder verzerrt sein und bilden oft gesellschaftliche Vorurteile ab. Wird ein Programm mit solchen Daten trainiert, kann es voreingenommen sein und eine Tendenz zur Exklusion bestimmter soziodemographischer Gruppen haben.

Datenschutz

Wenn Systeme automatisiert Entscheidungen treffen und mit personenbezogenen Daten operieren, stellt sich die Frage nach der Sicherheit dieser Daten. Wird etwa ein Algorithmus zur Personalrekrutierung verwendet, muss geregelt sein, wie die sensiblen privaten Daten der Mitarbeiter:innen und Bewerber:innen geschützt werden. Auch bei Sprachassistenten wie Amazons Alexa oder Google Home, die ständig "mithören", muss klar reguliert werden, was mit diesen privaten Aufnahmen passiert.

Manipulation und Transparenz

Dieser Aspekt ist vor allem demokratiepolitisch zentral. Schon jetzt können mit sogenannten "deep fakes" gezielt Meinungen manipuliert werden. Aber nicht nur Fälschungen, auch Algorithmen, die etwa auf Social Media bestimmte Inhalte höher reihen als andere, können zu einer Verzerrung des gesellschaftlichen Diskurses führen. Transparenzregeln werden hier in Zukunft immer wichtiger werden.

Verlust menschlicher Autonomie

Ein Thema, das in der Öffentlichkeit nicht so breit diskutiert wird wie Datenschutz oder verzerrte Daten, ist die Frage der menschlichen Autonomie. Für Sabine Köszegi ein zentrales Problem. "Immer dort, wo automatisierte Entscheidungssysteme Menschen die Arbeit abnehmen, verliert der Mensch an Handlungsmacht und damit letztendlich an Autonomie", erklärt Köszegi. Das zeigt, wie einschneidend die gesellschaftlichen Veränderungen durch den großflächigen Einsatz von KI sein werden und wie viele ethische Ebenen es zu beachten gilt.

"Ethically aligned design" und "Responsible Innovation" - Richtlinien und Best Practices für ethische KI

"In der Forschung setzen wir uns schon seit einiger Zeit mit ethischen Fragen der Technologieentwicklung auseinander", erzählt Köszegi. Auch der Feminismus habe dabei eine wichtige Rolle gespielt, nicht nur im Bereich der KI. "In der Automobilindustrie gab es nur Crashtest-Dummys, die auf den männlichen Körper zugeschnitten waren", so Köszegi. Von medizinischen Versuchen über ergonomische Standards war der männliche Körper die Norm. Dass Frauen dadurch systematisch benachteiligt und sogar direkt gefährdet wurden, musste erst durch feministische Kritik aufgezeigt werden. Auch in der KI-Entwicklung ist es zentral, mögliche Verzerrungen und Exklusion zu reflektieren. Von den Trainingsdaten über das Modelldesign bis hin zur Anwendung lauert Diskriminierungspotenzial:

Daten

KI-Systeme werden immer mit einer Fülle an Daten trainiert. Diese reflektieren gesellschaftliche Werte und Normen und müssen daher gründlich geprüft werden. "Daten können inkomplett, korrumpiert oder verzerrt sein", erklärt Köszegi.

Design

Die nächste Problemquelle ist die Zielsetzung des Modells. Was ist die Aufgabe? Will man einen Personalrekrutierungs-Algorithmus heranziehen, um die besten Mitarbeiterinnen und Mitarbeiter auszuwählen, steht man vor der Frage, wie diese Aufgabe definiert sein soll. Wer sind die besten Mitarbeiterinnen und Mitarbeiter? Ist Loyalität wichtiger als Durchsetzungskraft? Teamfähigkeit wichtiger als Führungsqualitäten? "Allein das Definieren eines guten Mitarbeiters oder einer guten Mitarbeiterin bringt eine Reihe von impliziten Werturteilen mit sich", erklärt Köszegi.

Anwendung

Letztlich kann auch der Einsatz des Systems zu neuen Verzerrungen führen, etwa durch missbräuchliche Verwendung. "Wenn ich etwa Kamerasysteme, die eigentlich für die Sicherheit der Mitarbeiter:innen gedacht sind, dazu verwende, um ihr Verhalten zu überwachen, dann ist das eine Zweckentfremdung eines KI-Systems, und auch das kann zu Benachteiligung führen."

Die Regulation der KI ist unumgänglich

© iStockphoto.comMenschenzentrierte KI: Wie funktioniert wertebasierte Technologieentwicklung?

Die EU-Kommission hat sich vorgenommen, diesen vielfältigen Herausforderungen mit einem menschenzentrierten Ansatz entgegenzutreten. Was aber heißt das? "Es ist ein wertebasierter Ansatz, mit besonderem Fokus auf die Grundrechte des Menschen", erläutert Köszegi. Zentral sei der Respekt für menschliche Autonomie, für Fairness und Inklusion und der Erhalt von menschlicher Kontrolle und Übersicht.

Wir sind weltweit die Ersten, die so umfassend regulieren, und zwar in einer sehr klugen Art und Weise

Im Rahmenwerk der EU heißt es "human in the loop", der Mensch muss zumindest an einem bestimmten Punkt Kontrollfunktionen haben. Für Sabine Köszegi zu wenig: Besser wäre "AI in the loop", also der Mensch muss während des gesamten Prozesses die Verantwortung und Übersicht behalten und soll sich nur bei bestimmten Aufgaben von der KI unterstützen lassen. Das Beispiel des autonomen Fahrens verdeutlicht die Idee: "Ich finde ein autonomes Fahrzeug nicht sinnvoll", so Köszegi, das sei erstens nur sehr schwer umsetzbar und führe zu einer Reihe von Problemen von Datenschutz bis Verantwortlichkeit. "Aber dass wir Bremsassistenzsysteme oder Einparkhilfen verwenden, ist absolut sinnvoll." Die menschliche Autonomie und Verantwortung bleibe erhalten und trotzdem könnten die offensichtlichen Vorteile von KI-Systemen gut genutzt werden.

Der EU AI-Act: Ein Meilenstein der KI-Regulation?

Ist der nun beschlossene EU AI-Act das richtige Instrument, um diesen menschenzentrierten Ansatz zu verwirklichen? Für Sabine Köszegi, die im Rahmen der "High-Level Expert Group" der EU-Kommission an den juristischen Richtlinien mitgewirkt hat, ist die Antwort ein klares Ja. Selbst wenn sich die Technologie noch dutzende Male verändern wird, das ethische Grundgerüst des EU AI-Acts bleibt. "Die Menschenrechte haben sich seit über 70 Jahren nicht geändert. Dieses Rahmenwerk, das die Grundprinzipien festlegt, ändert sich nicht", erklärt Köszegi.

Der EU AI-Act setzt auf einen risikobasierten Zugang. Nur Technologien mit hohem Gefahrenpotenzial sollen streng reguliert werden. Unproblematische Anwendungen von KI sollen dadurch nicht gebremst werden. "Wir sind weltweit die Ersten, die so umfassend regulieren, und zwar in einer sehr klugen Art und Weise. Weil wir nicht innovationshemmend, nicht überschießend regulieren, sondern eben mit diesem risikobasierten Ansatz", führt Köszegi weiter aus. Ungefährliche KI-Systeme, die etwa in der Landwirtschaft helfen, bleiben davon gänzlich unberührt und können in dem neu geschaffenen Raum regulatorischer Erwartungssicherheit sogar noch besser wachsen als ohne Regulation. Der EU AI-Act kann in diesem Sinne sogar Innovation und Wettbewerb fördern, denn Unternehmen wissen, worauf sie sich einstellen müssen und in welche Richtung sie Forschung und Investitionen lenken sollen.

Es wird transparenter sein und es muss mehr Mitbestimmung für die Nutzer:innen geben

Aber können europäische Unternehmen gegen die US-amerikanischen Tech-Giganten bestehen, die keiner solchen Regulation unterliegen? Auch amerikanische Firmen müssen sich an die Regeln des EU AI-Acts halten, sofern sie in Europa operieren wollen. "Die EU ist als Markt zu groß, man kann uns nicht vernachlässigen", erklärt Köszegi. Der EU AI-Act wird also auch über Europa hinaus Wirkung zeigen und kann zurecht als Startschuss einer handfesten juristischen Auseinandersetzung mit KI gesehen werden.

Zukunftsausblick

Wie geht es weiter? Wie wird sich die europäische KI-Entwicklung verändern? Wird der Tiktok-Feed also in Zukunft weniger manipulativ sein? Meine Youtube-Vorschläge weniger treffsicher? "Es wird transparenter sein und es muss mehr Mitbestimmung für die Nutzer:innen geben", prognostiziert Köszegi. Die genaue Umsetzung ist allerdings noch nicht ausdefiniert. In Österreich gibt es seit Dezember 2023 eine KI-Servicestelle, die die Bundesregierung bei der Umsetzung des AI-Acts beraten soll. Auch Sabine Köszegi ist Teil der Expertinnen- und Expertengruppe. Die nächsten Monate und Jahre werden also zeigen, ob der EU AI-Act tatsächlich eine nachhaltige Entwicklung von Künstlicher Intelligenz ermöglichen kann.